Amazon Web Services представила Trainium3 — собственный 3-нм ИИ-чип, который по соотношению цена/производительность до 50% выгоднее GPU Nvidia (инстансы P5e и P5en на базе H200). Клиенты вроде Anthropic, Ricoh и Decart уже используют платформу в обучении и инференсе ИИ.

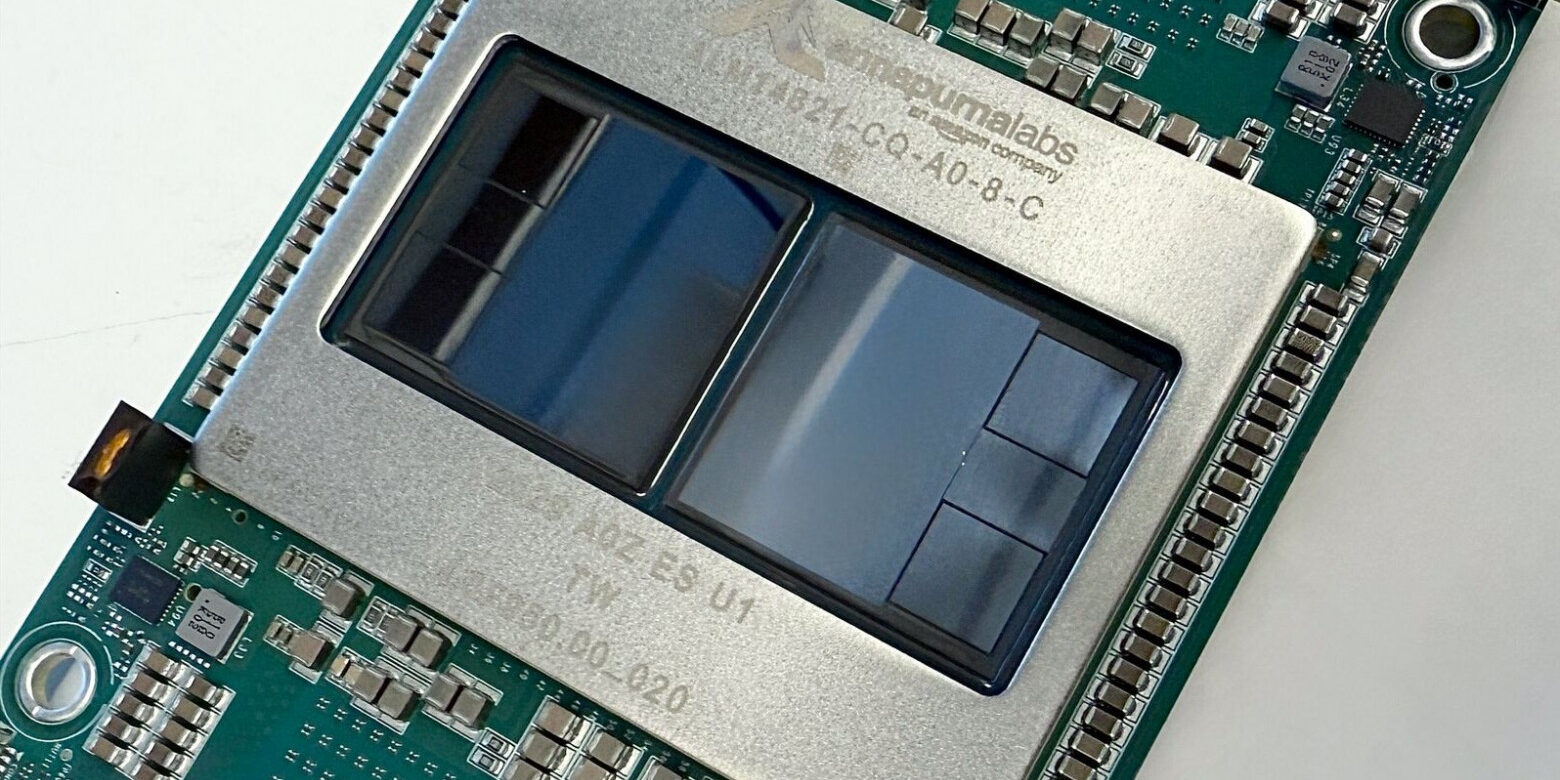

Каждый чип обеспечивает 2.52 петафлопса вычислений FP8, оснащен 144 ГБ памяти HBM3e с пропускной способностью 4.9 ТБ/с. Один UltraServer объединяет до 144 чипов и выдает 362 петафлопса, а кластеры EC2 UltraClusters 3.0 масштабируются до миллиона ускорителей — в 10 раз больше предыдущего поколения.

В сравнении с Trainium2 новый чип обеспечивает прирост производительности в 4.4 раза, четырехкратное увеличение энергоэффективности и почти четырехкратный рост пропускной способности памяти. В тестах на открытой модели OpenAI GPT-OSS клиенты получили троекратный рост пропускной способности на чип и четырехкратное ускорение инференса.

Среди первых пользователей — Anthropic, которая будет использовать чип для новых версий Claude. Стартап Decart сообщает о четырехкратном ускорении генерации видео при половине стоимости GPU. Отдельные клиенты заявляют об экономии до 50% на обучении и инференсе.

Параллельно AWS анонсировала Trainium4 — следующее поколение с минимум трехкратным приростом FP8 и шестикратным FP4. Ключевая деталь: чип будет поддерживать NVIDIA NVLink Fusion, что позволит ему работать в одной стойке с GPU Nvidia.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть«, где я рассказываю про ИИ с творческой стороны.